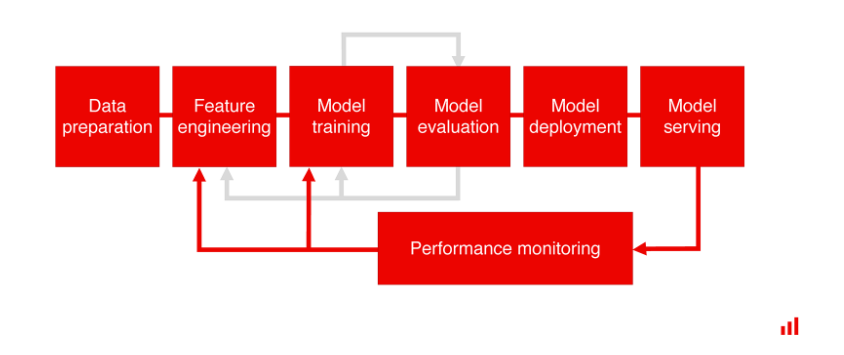

머신러닝 모델을 배포하고 성능을 모니터링하는 작업은 중요하다.

data drift가 발생할 수 있기 때문이다.

팀에 위처럼 퍼포먼스 모니터링 시스템이 갖춰진 경우는 예외겠지만,

많은 모델의 퍼포먼스 모니터링 시스템까지 갖춰진 경우는 많지 않은듯 하다.

특히 ad-hoc으로 오는 분석 및 모델링 작업같은 경우에 모니터링 자료를 만드는 데 생각보다 리소스가 많이 들기도 한다.

이 문제를 해결해 줄

텐서플로우 벨리데이션(tensorflow validation), 딥첵(deepchecks) 그리고 Evidently 와 같은 무료 오픈소스 tool 들이 있는데, 개인적으로는 Evidently가 진행했던 프로젝트들에 적합했던 것 같다.

Evidently 사용 예시

https://www.kaggle.com/code/kimtaehun/ml-deployment-how-to-monitor-ml-performance

[ML deployment]How to monitor ML performance?

Explore and run machine learning code with Kaggle Notebooks | Using data from multiple data sources

www.kaggle.com

아래 파일처럼 html 파일로 대시보드를 만들어준다.

혹은 직접 노트북에서 확인이 가능하지만 데이터가 크다면 매우 느려 열리지 않을 가능성이 높다....

레퍼런스(기준 데이터 및 퍼포먼스)와 새로운 데이터(혹은 기간)를 비교해 성능을 보여준다.

세부적인 내용은 커스터마이징이 가능해 매우 편리하다.

그 외에 다른 Tool들도 많지만....혹시 알고 싶다면 아래 블로그를 추천!

Tensorflow data validation

source: https://towardsdatascience.com/top-3-python-packages-for-machine-learning-validation-2df17ee2e13d

Top 3 Python Packages for Machine Learning Validation

Validate your machine learning model with these packages

towardsdatascience.com